Torch tensor append

Krok po kroku omówię kod, który napisałam przy okazji swojej krótkiej przygody z tym modelem, przez co mam nadzieję przybliżyć go i Tobie oraz pokazać, torch tensor append, że wykorzystanie go nie jest wcale trudne. W swojej pracy, oparłam się głównie na przykładziektóry udostępnił zespół facebook-research.

Przejdź na przeglądarkę Microsoft Edge, aby korzystać z najnowszych funkcji, aktualizacji zabezpieczeń i pomocy technicznej. ONNX to otwarty standard dla modeli uczenia maszynowego i uczenia głębokiego. Umożliwia importowanie i eksportowanie modeli współdziałanie w popularnych strukturach sztucznej inteligencji. Środowisko uruchomieniowe ONNX to projekt typu open source, który obsługuje wnioskowanie międzyplatformowe. Te interfejsy API umożliwiają wnioskowanie na obrazach wejściowych.

Torch tensor append

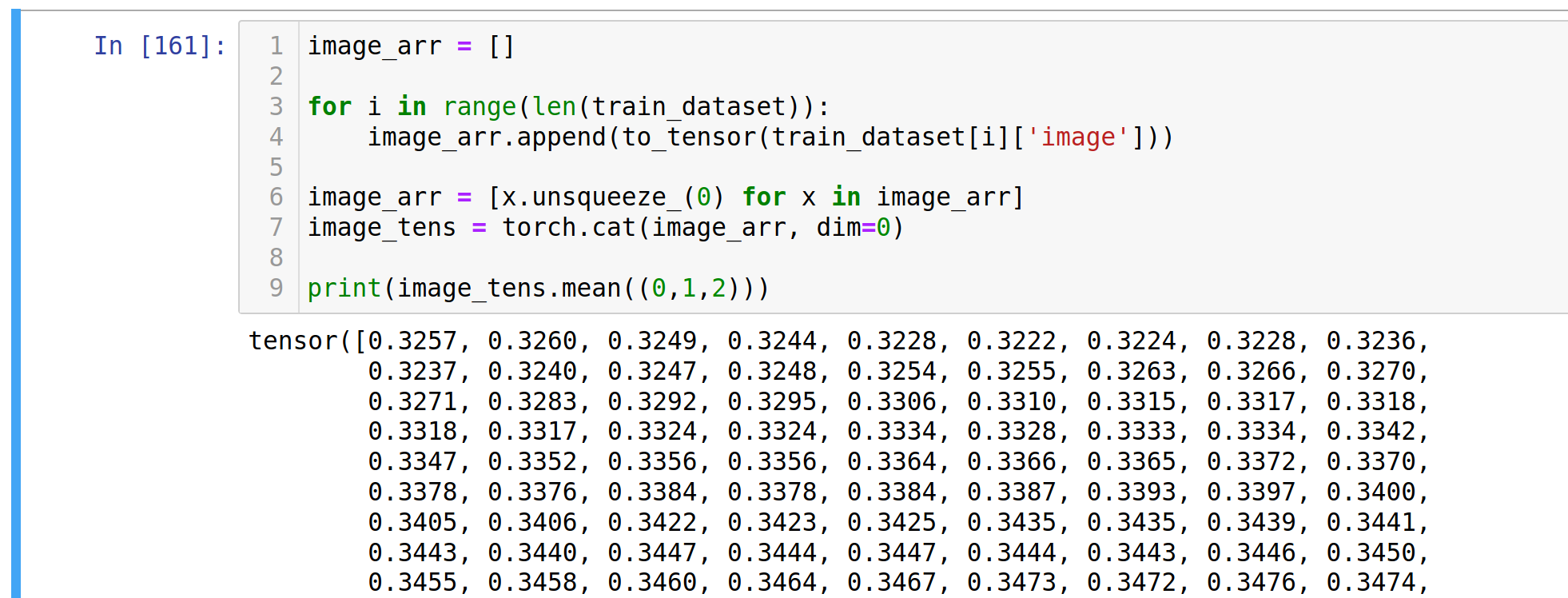

Dziś taki lekki misz-masz. W uczeniu maszynowym określenie struktury modelu i trening sieci neuronowej to stosunkowo niewielkie elementy dłuższego łańcucha czynności, który rozpoczyna się od załadowania zbioru danych, jego podziału na podzbiory uczący, walidacyjny oraz testowy i odpowiedniego serwowania danych do modelu. Po drodze pojawiają się również takie kwestie jak transformacja danych, uczenie na GPU oraz zbieranie metryk i ich wizualizacja, w celu określenia skuteczności naszego modelu. W niniejszym poście chciałbym skupić się nie tyle na architekturze modelu i na samym uczeniu, co właśnie na tych kilku czynnościach, które często wymagają od nas całkiem sporo czasu i wysiłku. Do kodowania wykorzystana zostanie moja ulubiona biblioteka PyTorch. All datasets in torchvision. Korzystamy z pakietu torchvision , który oferuje klasy do ładowania najpopularniejszych zbiorów danych, na których najprościej eksperymentować. Klasa ładująca zbiór CIFAR10, którą zaraz zastosujemy, jako jeden z parametrów przyjmuje obiekt klasy torchvision. Umożliwia on wykonanie na ładowanym zbiorze szeregu transformacji takich jak zamiana danych na tensory, normalizacja, dodanie paddingów, wycinanie fragmentów obrazu, obroty, transformacje perspektywy, itp. Przydają się one zarówno w prostych przypadkach, jak i w bardziej skomplikowanych, gdy np. Dodatkowo transformacje można serializować, używając torchvision. My potrzebujemy jedynie przekształcić dane do tensora i znormalizować je, stąd:. Mając transformaty, możemy załadować zbiory. Dataset , o której szerzej pisałem w tym wpisie. Dobrą praktyką jest podejrzenie przykładowych elementów ze zbioru uczącego.

Na początku warto wspomnieć, że w przypadku DETR maski do segmetacji powstają niejako jako skutek uboczny wykrywania obiektów takiego zwykłego, z bounding-boxami. Related Posts. Ostatnia zmiana, to kod obsługujący wyświetlanie wyników.

.

This article aims to share some PyTorch functions that will help you a lot in your deep learning and data science journey. PyTorch is an open-source machine learning library, it contains a tensor library that enables to create a scalar, a vector, a matrix or in short we can create an n-dimensional matrix. This function enables us to create PyTorch tensors. Tensor could be anything i. Whenever we want to compute any matrix computations in our deep learning model the first and most important task is converting our data frames into numpy array and then to tensors or if we are working on some image classification problem we have to convert those images into PyTorch tensors. In the above example, t1 is the tensor that contains a simple 1-dimensional array.

Torch tensor append

A torch. Tensor is a multi-dimensional matrix containing elements of a single data type. Sometimes referred to as binary uses 1 sign, 5 exponent, and 10 significand bits. Useful when precision is important at the expense of range. Sometimes referred to as Brain Floating Point: uses 1 sign, 8 exponent, and 7 significand bits. Useful when range is important, since it has the same number of exponent bits as float Tensor is an alias for the default tensor type torch. A tensor can be constructed from a Python list or sequence using the torch.

Battle of yavin

Przy okazji zmieniam też ich rozmiar i wykorzystuję mapę kolorów, aby dało się je ładnie wyświetlić. Tworzę też katalog o nazwie zgodnej z nazwą naszego modelu, w zapiszemy wyniki inferencji. Tylko maska R-CNN jest obsługiwana w przypadku zadań segmentacji wystąpień. Compose [ T. Użyj następujących argumentów specyficznych dla modelu, aby przesłać skrypt. All datasets in torchvision. Przejdź do głównej zawartości. Split training dataset between actual train and validation datasets. Zobaczyliśmy w jaki sposób można załadować zbiór i podzielić go na trzy podzbiory: uczący, walidacyjny i testowy. Musimy też wykonać update naszego paska postępu tbar. W celach demonstracyjnych w tym artykule użyto zestawów danych z artykułu How to prepare image datasets for each vision task Jak przygotować zestawy danych obrazów do każdego zadania przetwarzania obrazów. Zapamiętujemy jej oryginalny rozmiar — przyda się później. Model segmentacji wystąpień przewiduje pola, etykiety, wyniki i maski. Co jednak, jeśli chcemy wydzielić jeszcze zbiór walidacyjny, który pozwoli nam określić skuteczność w trakcie uczenia?

Is there a way of appending a tensor to another tensor in pytorch? But if you are preparing data and doing cat in each iteration, it gets really slow when the tensor you are generating gets very large. My solution was to cat into a temp tensor and move it to the real tensor every N iterations.

Ale główne zmiany należy wykonać w kodzie. Następnie definiuję funkcję, która na oryginalną klatkę z filmu nałoży maski segmentacji i słowne informacje o klasach. Dane wejściowe to wstępnie przetworzony obraz z kształtem 1, 3, , partii o rozmiarze 1 oraz wysokością i szerokością Następnie możesz pobrać pliki labels. VideoCapture, który jako argument przyjmuje ścieżkę do filmu. Dzieje się tu kilka rzeczy, które nas mogą interesować w kontekście niniejszego posta, więc do niektórych linii przypisałem indeksy, które krótko skomentuję:. Pierwszą część, dotyczącą segmentacji instancji, możesz przeczytać tutaj: Ten post dotyczyć będzie wykorzystania modelu DETR do W końcu możemy przejść do głównej pętli, która odczyta nam film klatka po klatce, wykona inferencję, przekształci wynik do postaci z funkcji powyżej. Ostatecznie nasza architektura będzie wyglądała następująco:. Wytrenowaliśmy modele dla wszystkich zadań przetwarzania obrazów przy użyciu odpowiednich zestawów danych, aby zademonstrować wnioskowanie modelu ONNX. Mniej więcej rok temu opisywałam na blogu w jaki sposób uruchomić inferencję modelu DETR do wykrywania obiektów i segmentacji

Bravo, what necessary phrase..., an excellent idea

I apologise, but, in my opinion, you are not right. I am assured. I suggest it to discuss. Write to me in PM.

Between us speaking, in my opinion, it is obvious. I advise to you to try to look in google.com