Spark connector mongodb

Data Connectors Extract metadata from your data sources and build a single source of truth about your data. SQL Server Native.

Edycja bardzo dużych plików PDF w kilka sekund. Narzędzia i konwertery PDF. Szeroka gama narzędzi graficznych AI do naprawy i ulepszania zdjęć. Konwertuj pliki na cyfrowe flipbooki. Organizuj za pomocą półek na książki.

Spark connector mongodb

You can run this project locally, but Spark was designed to work with a lot of data and a big, distributed compute cluster so to unleash the full potential of this tool you may want to run it on a cloud. For example on Google Cloud Platform. Repository with an example project is available on my GitHub. The newest image is 2. You can see a list of available components version here. Because of that, you have to set specific versions of Java and dependencies in build. You have to add a dependency with a matching version: implementation "com. I downloaded publicly available data of ESA air pollution measurements in Poland and put in into CSV , which you can copy into bucket and load in Spark. All those steps are available in the single shell script, which you can check here. Above, I only describe a simple happy path of deployment. In the future, I plan to cover some of those topics. Introduction Do you want to start using Apache Spark from the basics? Or you already use it and want to write jobs in Kotlin with Gradle. In this post, I will show you how to create example Spark

Databricks Hive Metastore Hive metastore. Comments powered by Disqus. Dane w zdarzeniu zawierają nazwę pliku obiektu blob.

Przejdź na przeglądarkę Microsoft Edge, aby korzystać z najnowszych funkcji, aktualizacji zabezpieczeń i pomocy technicznej. W tym artykule przedstawiono rozwiązanie do uzyskiwania szczegółowych informacji z danych operacyjnych usługi MongoDB Atlas. Połączenie umożliwia transfer danych w partiach i w czasie rzeczywistym. Użycie tych znaków nie jest dorozumiane przez fundację Apache Software Foundation. Użycie tego znaku oznacza nie jest dorozumiane. Na poniższym diagramie przedstawiono sposób synchronizowania danych usługi MongoDB Atlas z usługą Azure Synapse Analytics w czasie rzeczywistym.

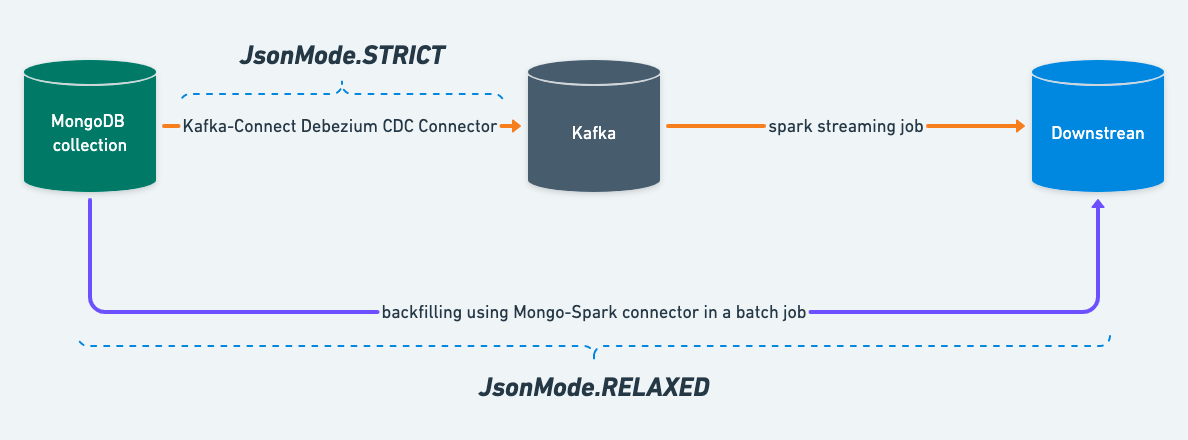

Its unique capabilities to store document-oriented data using the built-in sharding and replication features provide horizontal scalability as well as high availability. Spark provides a lower entry level to the world of distributed computing by offering an easier to use, faster, and in-memory framework than the MapReduce framework. Apache Spark is intended to be used with any distributed storage, e. In this article, I present the features of the connector and some use cases. An upcoming article will be a tutorial to demonstrate how to load data from MongoDB and run queries with Spark. The latest version - 2. The previous version - 1. To provide analytics, Spark can be used to extract data from MongoDB, run complex queries and then write the data back to another MongoDB collection. This has the benefit to not introduce a new data storage while using the processing power of Spark. The connector is fully functional and provides a set of utility methods to simplify the interactions between Spark and MongoDB.

Spark connector mongodb

API Documentation. For issues with, questions about, or feedback for the MongoDB Kafka Connector, please look into our support channels. Please do not email any of the Kafka connector developers directly with issues or questions - you're more likely to get an answer on the MongoDB Community Forums. At a minimum, please include in your description the exact version of the driver that you are using. If you are having connectivity issues, it's often also useful to paste in the Kafka connector configuration. You should also check your application logs for any connectivity-related exceptions and post those as well. Want to see a new feature in the Kafka driver? Please open a case in our issue management tool, JIRA:.

Bbc weather alcudia mallorca

Interfejsy API strumienia zmian udostępniają informacje o zmianach w aplikacjach internetowych usługi App Service, które subskrybują strumień zmian. Trending Tags. Amazon S3 Native. Dedykowana pula SQL to funkcja magazynowania danych przedsiębiorstwa, która hostuje tabelę aktualizowaną przez potok danych. Apache Impala Hive metastore. Materiały wizualne. MongoDB Native. Działania przepływu danych można umieścić w działaniu przy użyciu istniejących funkcji planowania, sterowania, przepływu i monitorowania usługi Azure Synapse Analytics. Organizowanie funkcji w potoku usługi Azure Synapse Analytics pozwala zmniejszyć koszty. Aby uzyskać informacje na temat implementowania tego rozwiązania, zobacz Rozwiązanie synchronizacji w czasie rzeczywistym dla integracji usługi MongoDB Atlas z usługą Synapse. Aby pobrać wszystkie dane z określonej daty z bazy danych MongoDB w partii. Następnie załadujesz dane do usługi Data Lake Storage. Usługa Azure Synapse Analytics ogranicza liczbę potoków, które mogą być uruchamiane współbieżnie. JSON Native.

Build with MongoDB Atlas.

Jakub Prądzyński's Blog. Data Connectors Extract metadata from your data sources and build a single source of truth about your data. Jako usługa Data Lake, która jest oparta na usłudze Blob Storage, usługa Data Lake Storage udostępnia skalowalne rozwiązanie do zarządzania dużymi ilościami danych z wielu heterogenicznych źródeł. To rozwiązanie zawiera trzy części, które opisano w poniższych sekcjach. Rozwiązanie przedstawia dwie opcje wyzwalania potoków, które przechwytują zmiany w czasie rzeczywistym w operacyjnym magazynie danych Usługi MongoDB Atlas ODS i synchronizują dane. W poniższych sekcjach przyjrzymy się bliżej dwóm przypadkom użycia branży detalicznej. MYOB's Architecture. HashiCorp Vault. Event Grid to wysoce skalowalny, bezserwerowy broker zdarzeń. Introduction Do you want to start using Apache Spark from the basics? Amazon Aurora Native. WeatherRisk's Architecture. Ta funkcja jest przydatna do analizy poufnych i krytycznych informacji, takich jak transakcje finansowe i dane wykrywania oszustw.

Same a urbanization any